最新讯息

WPG AI Box,加速Edge AI应用开发

人工智能Artificial intelligence (AI) 正在从一个概念走向各行各业,实现不同应用环境的实际落地。在这个过程中,将数据处理与分析移至边缘(Edge)在距离数据产生更近的地方完成部分运算 (Edge AI),将有助于加快系统响应速度,用于处理能力更敏捷、延迟更低、安全性更好的各种AI应用解决方案中。

WPG 大联大控股是英特尔物联网解决方案聚合商,为亚洲及大中华地区的IT系统整合商以及OT系统整合商提供服务,结合ODM/OEM/ISV整合联网解决方案。为了帮助合作伙伴更有效、更快速地完成AI解决方案的开发与构建,WPG基于Intel AI Box设备以及合作伙伴的相关AI开发服务,提供了AI加速器工具套件等一系列先进的软硬件服务与技术,加速Edge AI应用的开发。

其中,智能视觉以旺盛的市场需求和广泛的应用场景受到用户青睐。基于Edge AI的视觉应用分析解决方案已广泛应用于智能城市、智能小区、智能交通、智能制造、智能零售等10多个领域。

构建性能卓越、应用场景广泛的Edge AI视觉分析能力,离不开多种算法和高性能算力的有效结合。这不仅需要强大的硬件平台来承载计算器视觉和推论所需的密集计算负载,还需要合适的开发工具和软件框架来完成AI加速,进一步刺激生态系统,为更多应用环境提供解决方案。WPG AI加速器工具套件包含:

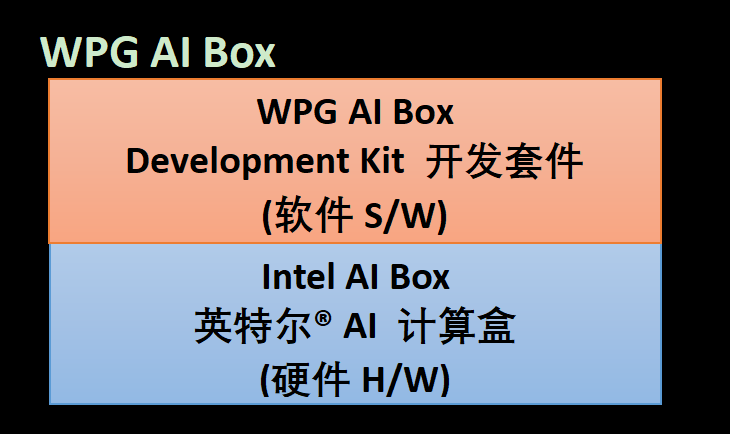

WPG AI Box = Intel AI Box (硬件) + WPG AI Box Development Kit (软件)

1. Intel AI Box英特尔AI计算盒 (硬件H/W)

英特尔在AI Box中加入了全新第11代英特尔酷睿TM处理器,以出色的基础算力、图形/媒体和AI加速能力,说明解决方案实现处理性能、可用性、稳定性和安全性等多方面飞跃。WPG硬件方面采用Intel 11代(Tiger Lake) 为主的 AI Box,以出色的基础算力、图形/媒体和AI加速能力,实现处理性能、可用性、稳定性和安全性等多方面提升。目前WPG Intel AI Box的合作伙伴有Giada、Nexcom等等…

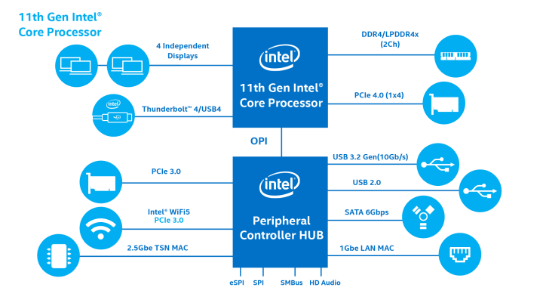

第11代Intel® CoreTM处理器提供具有整合式人工智能加速功能的高效能CPU/GPU运算,加上需要高速处理、计算机视觉和低延迟确定性运算的应用功能。它们在基于第三代10奈米制程技术的低功耗平台中带来效能与响应能力之间的平衡(与第8代Intel® CoreTM处理器*相比,单线程效能提升高达23%,而多线程效能则提升高达19%),同时提供了Intel® Iris® Xe显示芯片、PCI Express 4.0与ThunderboltTM 4/USB4。

最多可达96个执行单元,其绘图效能将达到第8 代Intel® CoreTM处理器*的2.95倍,双视讯译码盒(可在每秒30影格的速度下,同时处理最多达40道1080p串流)可驱动最多达四部独立的4K HDR显示器或两个8K SDR输出。该平台还同时透过CPU与整合式GPU,透过Intel® Deep Learning Boost功能提供人工智能。

特别是在加速人工智能与计算机视觉方面: Intel® Deep Learning Boost (Intel® DL Boost) 透过CPU上的全新向量神经网络指令提升推论效能,该指令将三项指令合而为一推论应用程序还可利用GPU上高达96EU 来执行8位整数算法

2.WPG AI Box Development Kit开发套件 (软件 S/W)

在软件方面WPG提供AI Box Development Kit,从多个方面为合作伙伴提供视觉处理、模型优化、AI 推论加速等多维度的软件支持,加速产品开发、优化性能表现、缩短上市时间。WPG的AI Box Development Kit,建立在Docker Container之上,方便客户可快速选择、建立适当的产品。

我们将AI inference(推论)所需的全功能软件reference code以container方式打包,我们的软件包含了影像AI推论所需的必要功能,多channel影像输入译码、影像前处理、AI推论、影像后处理、影像编码,可将推论结果透过异质协议后传到客户端之环境,也可在local端建立dashboard实时呈现状况,因此客户可依需求修改必要之image而不用整个项目从0开始开发,大大缩短产品落地的时间。

WPG AI Box 使用OpenVINO toolkit,能够更有效支持从边缘(Edge)到云端(Cloud)的深度学习推论。一方面,该工具套件通过优化的传统计算机视觉库对方案的媒体性能提供了巨大的增强;另一方面,其包含了模型优化器和推论引擎两个核心组件,其中,模型优化器能通过数据格式转换等方法,使得 AI 算法模型在目标设备上实现更优执行能力;推论引擎则可针对不同硬件平台 (CPU、GPU、VPU等) 实现异构部署,用户一次开发,即可针对不同平台获得出色性能。

值得一提的是,OpenVINOTM工具套件还可借助 Open Model Zoo 提供的百多个经过预先训练,且优化过的模型和范例 (涵盖物体检测、物体识别、行为检测、图像处理等一系列常见且实用的 AI 模型),帮助合作伙伴加快边缘AI视觉分析应用开发。

Reference

1. 数据源:Intel 第十一代智能英特尔® 酷睿TM处理器

https://www.intel.cn/content/www/cn/zh/products/docs/processors/core/11th-gen-core-enhanced-for-iot-brief.html

2. Docker: https://www.docker.com/

Docker是一种软件平台,可让您快速地建立、测试和部署应用程序。Docker将软件封装到名为容器(Container)的标准化单位,其中包含链接库、系统工具、程序代码和运行时间等执行软件所需的所有项目。使用 Docker,您可以将应用程序快速地部署到各种环境并加以扩展。

3.图3来源: https://www.intel.cn/content/www/cn/zh/products/platforms/details/tiger-lake-up3.html?elq_cid=4538983_ts1655082053912&erpm_id=7434619_ts1655082053912

4.Intel OpenVINOTM: https://www.intel.cn/content/www/cn/zh/developer/tools/openvino-toolkit/overview.html